Resumen

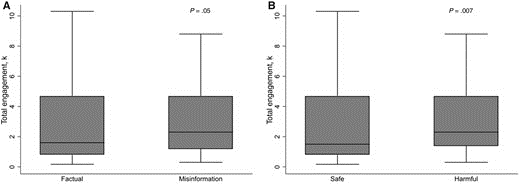

Hay pocos datos sobre la calidad de la información sobre el tratamiento del cáncer que está disponible en las redes sociales. Aquí cuantificamos la precisión de la información que proveen las redes sociales sobre el tratamiento del cáncer y su potencial para dañar. Dos expertos en cáncer revisaron 50 de los artículos más populares que están disponibles en las redes sociales para cada uno de los cuatro tipos de cáncer más frecuentes. Se informa sobre el porcentaje de la información errónea y del potencial de 200 artículos de producir daños, así como de su asociación con las interacciones con los usuarios de las redes sociales mediante una prueba de suma de rangos de Wilcoxon de 2 muestras. Todas las pruebas estadísticas fueron de dos colas. De los 200 artículos, el 32,5% (n = 65) contenía información errónea y el 30,5% (n = 61) contenía información perjudicial. Entre los artículos que contenían información errónea, el 76,9% (50 de 65) contenían información perjudicial. La mediana del número de interacciones entre los usuarios de las redes sociales y los artículos con información errónea fue mayor que con los artículos con información objetiva (mediana [IQR] = 2.300 [1.200-4.700] frente a 1.600 [819-4.700], P=0,05). La mediana del número de interacciones con los artículos con información perjudicial fue significativamente mayor que con los artículos con información segura (mediana [IQR] = 2.300 [1.400-4.700] frente a 1.500 [810-4.700], P=0,007).

Internet es una de las principales fuentes de desinformación sobre la salud [1]. Esto es especialmente cierto en el caso de las redes sociales, donde la información falsa se difunde con mayor rapidez y amplitud que la información contrastada [2]. La desinformación sobre la salud es una amenaza para la salud pública y de debe abordar con urgencia [3-6], ya que obstaculiza la prestación de una medicina basada en la evidencia, afecta negativamente a las relaciones entre el paciente y el médico y puede aumentar el riesgo de muerte [7-10]. Dado que los pacientes utilizan las redes sociales para obtener información en salud, abordar la desinformación se ha convertido en un objetivo fundamental de la salud pública [11]. Esto es especialmente cierto en el tratamiento contra el cáncer, donde el uso de terapias no probadas se asocia con menor supervivencia [10]. Aquí cuantificamos la exactitud de la información sobre el tratamiento del cáncer en las redes sociales, su potencial para dañar y cómo las interacciones con los usuarios de las redes sociales difieren según la veracidad de la información y la posibilidad de dañar.

Utilizando un software de rastreo web (Buzzsumo.com) [12], buscamos los artículos más populares en inglés que contenían palabras clave relevantes para los cuatro tipos de cáncer más frecuentes (mama, próstata, colorrectal y pulmón). Estos artículos incluyen cualquier artículo, noticia o blog publicado en Facebook, Reddit, Twitter o Pinterest entre enero de 2018 y diciembre de 2019. Cada artículo tenía un enlace único (URL), que permite tabular las interacciones con los usuarios, definidas como upvotes (Twitter y Pinterest), comentarios (Reddit y Facebook), y reacciones y ítems compartidos (Facebook). Así, las “interacciones totales” corresponde al agregado de las interacciones en las múltiples plataformas. Se recopilaron los 50 mejores artículos de cada tipo de cáncer, lo que representa 200 artículos únicos. La gran mayoría de las interacciones ocurrieron de Facebook y se analizaron por separado.

Se seleccionaron dos miembros del panel de la National Comprehensive Cancer Network como expertos en contenido de cada sitio (mama: MM/JW; próstata: TD/DS; colorrectal: SC/JH; y pulmón: JB/WA). Los expertos en contenido revisaron las afirmaciones médicas primarias y completaron sus evaluaciones respondiendo a cuatro preguntas, adaptadas a partir de las evaluaciones de la veracidad y la credibilidad de los medios sociales [13, 14] y a través de un proceso iterativo con LS, JT y AF para tener en cuenta las afirmaciones específicas sobre el cáncer

(Figura suplementaria 1). Los revisores expertos no fueron compensados.

Los expertos utilizaron dos escalas de Likert de 5 puntos por artículo (Figura suplementaria 1, disponible en línea), y se sumaron las calificaciones de los dos revisores por artículo dentro de cada dominio. La información errónea se definió como aquellas que recibieron puntuaciones mayores o iguales a 6, que representaban una “mezcla de información verdadera y falsa”, “mayoritariamente falsa” y “falsa”, y la información se consideró perjudicial cuando al menos un evaluador dijo que era “probablemente perjudicial” y/o “ciertamente perjudicial”. La concordancia entre revisores se evaluó mediante el coeficiente kappa (ĸ) de Cohen. Se informó la proporción de artículos clasificados con información errónea y perjudicial, y se explicaron los motivos por los que los artículos fueron calificados así, permitiéndose las selecciones múltiples.

La asociación entre las interacciones totales y con Facebook y la desinformación y la posibilidad de dañar se evaluó mediante una prueba de suma de rangos de Wilcoxon (Mann-Whitney) de dos muestras. Los análisis estadísticos se realizaron con Stata, versión 16.1 (StataCorp). Todas las pruebas estadísticas fueron de dos colas, y se consideró que una p menor de 0,05 era estadísticamente significativa.

De los 200 artículos, el 37,5% (n = 75), el 41,5% (n = 83), el 1,0% (n = 2), el 3,0% (n = 6) y el 17,0% (n = 34) procedían, respectivamente, de noticias tradicionales (versiones en línea de medios impresos y/o audiovisuales), noticias no tradicionales (sólo digitales), blog personal, sitio de crowdfunding y revistas médicas, respectivamente. Tras la revisión por expertos, el 32,5% (n = 65; ĸ = 0,63, intervalo de confianza [IC] del 95% = 0,50 a 0,77) contenía información errónea, descrita con mayor frecuencia como engañosa (título no respaldado por el texto, estadísticas/datos que no apoyaban la conclusión [28,8%, 111 de 386]), fuerza de la evidencia mal caracterizada (evidencia débil presentada como fuerte o viceversa [27,7%, 107 de 386]), y terapias no probadas (no estudiadas, evidencia insuficiente [26,7%, 103 de 386]).

En total, el 30,5% (61 de 200; ĸ = 0,66, IC del 95% = 0,52 a 0,80) de los ítems contenían información perjudicial, descrita como inacción perjudicial (podría llevar a retrasar o no buscar atención médica para una condición tratable o curable [31.0%, 111 de 358]), daño económico (costes financieros de bolsillo asociados al tratamiento o al desplazamiento [27,7%, 99 de 358]), acción perjudicial (efectos potencialmente tóxicos de la prueba o el tratamiento sugeridos [17,0%, 61 de 358]) o interacciones perjudiciales (interacciones médicas conocidas o desconocidas con terapias curativas [16,2%, 58 de 358]). En la tabla suplementaria 1 (disponible en línea) se presenta una selección de ejemplos cualitativos de las afirmaciones médicas primarias realizadas para cada pregunta de evaluación. Entre los artículos que contenían información errónea, el 76,9% (50 de 65) contenían información perjudicial.

La mediana del número de interacciones fue de 1.900 (rango intercuartil [IQR] = 941-4.700), y el 96,7% fueron interacciones en Facebook. La mediana de interacción con los ítems con información errónea fue mayor que con los artículos objetivos (mediana [IQR] = 2.300 [1.200-4.700] frente a 1.600 [819-4.700], P = 0,05) (Figura 1, A; Cuadro 1). La mediana de interacción con los ítems con información nociva fue significativamente superior que con los artículos que presentaban información segura (mediana [IQR] = 2.300 [1.400-4.700] frente a 1.500 [810-4.700], P = 0,007) (Figura 1, B; Cuadro 1). Estos resultados fueron consistentes para las interacciones en Facebook (Cuadro 1). Las interacciones en Reddit y Twitter se asociaron de forma estadísticamente significativa con la desinformación y el daño (todos los resultados son P < 0,05). Sin embargo, las interacciones en Pinterest no se asociaron con la desinformación ni con el daño (todos los P > 0,63).

Entre 2018 y 2019, casi un tercio de los artículos populares en las redes sociales sobre el cáncer contenían información errónea y el 76,9% de estos contenían información perjudicial. Estos datos muestran que la información sobre el cáncer en los medios sociales a menudo es inconsistente con la opinión de los expertos. Esto deja a los pacientes en la confusa e incómoda posición de establecer por sí mismos o hablando con su médico la veracidad de la información online. Lo más preocupante es que, entre los ítems más populares en Facebook, hubo mayor interacción con aquellos que contenían información errónea y perjudicial, y esa asociación fue estadísticamente significativa. Esto podría lograr que se perpetuara la desinformación perjudicial, especialmente dentro de silos de información que monitorean personas susceptibles a verse influenciados por esa información.

Las limitaciones de este estudio son que sólo incluimos los artículos más populares sobre el cáncer en inglés. Además, aunque los datos de BuzzSumo se obtienen directamente de la interfaz de programación de la aplicación de medios sociales [12], existe una pequeña posibilidad de que este conjunto de datos esté incompleto o de que las interacciones no coincidan con los registrados internamente por las plataformas. Los datos carecen de información cualitativa importante, pero se determinó que esto estaba fuera del alcance de este informe. Por último, es posible que los revisores se hubieran inclinado por los tratamientos oncológicos convencionales; sin embargo, las preguntas se estructuraron para evitar la estigmatización de los tratamientos oncológicos no tradicionales.

En conjunto, estos datos muestran que un tercio de los artículos populares sobre el cáncer que circularon en las redes sociales en 2018 y 2019 contienen información errónea, y la mayoría de ellos pueden causar un daño. Se están haciendo estudios sobre la capacidad de discriminación de los pacientes, la identificación de las poblaciones en riesgo de adopción de información errónea y los factores que pueden predecir la confianza en la desinformación sobre el cáncer que se presenta en línea. Es necesario seguir investigando para saber quiénes son los que se dedican a desinformar sobre el cáncer, su impacto en el conocimiento científico, en la confianza y en las decisiones, y el papel de la comunicación médico-paciente para corregir la desinformación. Estos resultados podrían ayudar a sentar las bases para desarrollar herramientas específicas que ayuden a los pacientes e intervenciones conductuales para contrarrestar la desinformación sobre el cáncer que aparecen en las redes sociales.

Financiación

Este estudio fue financiado, en parte, por el Huntsman Cancer Institute.

Notas

El papel del financiador: El financiador no participó en el diseño del estudio, la recopilación, el análisis y la interpretación de los datos, la redacción del manuscrito ni la decisión de presentarlo para su publicación.

Divulgación de información: El Dr. Johnson y el Dr. Parsons tuvieron pleno acceso a todos los datos del estudio y asumen la responsabilidad de la integridad de los datos y la exactitud del análisis de los mismos. Skyler B.Johnson, MD, no tiene conflictos de intereses financieros. La doctora Jessica Baumann forma parte de los consejos asesores de Pfizer y Kura. Stacey Cohen, MD está en las juntas asesoras de Kallyope, Acrotech, Natera, recibe dinero de subvenciones de NIH P30-CA015704-44 y a través de fondos de investigación institucionales incluyendo Boston Biomedical/ Sumitomo Dainippon Pharma Oncology, Isofol,y Polaris. La Dra. Tanya Dorff forma parte de los consejos asesores de Abbvie, Advanced Accelerator Applications, Bayer, BMS, Exelixis, Janssen y Seattle Genetics. La doctora Joleen Hubbard forma parte de los consejos asesores de Bayer y Taiho y recibe financiación para la investigación de su institución de Merck, Boston biomedical, Treos Bio, Taiho, Senhwa pharmaceuticals, Bayer, Incyte, TriOncology, Seattle Genetics y Hutchinson MediPharma. El doctor Daniel Spratt recibe honorarios personales de Janssen, Bayer, AstraZeneca y Blue Earth, así como financiación de Janssen.

Todos los demás investigadores informaron de que no había conflictos de intereses financieros.

Disponibilidad de datos

Los datos en los que se basa este artículo están disponibles en línea y los conjuntos de datos proceden de fuentes de dominio público: buzzumo.com.

Referencias