A inteligência artificial (IA) generativa foi capaz de materialisar rapidamente grandes quantidades de desinformação sobre saúde em relação a vacinas e a vaporizadores, descobriram pesquisadores australianos.

Em apenas 65 minutos e seguindo instruções básicas, o ChatGPT produziu 102 artigos de blog contendo mais de 17.000 palavras de desinformação sobre esses dois assuntos, relataram Ashley Hopkins, PhD, da Flinders University de Adelaide, Austrália, e seus colegas no JAMA Internal Medicine.

Hopkins e seus colegas também conseguiram usar duas outras ferramentas de IA generativas – DALL-E 2 e HeyGen – para produzir 20 imagens realistas além de um vídeo deep-fake em menos de 2 minutos para acompanhar as postagens de desinformação no blog.

Embora o ChatGPT da OpenAI tenha produzido a desinformação com facilidade, dois outros programas de IA generativa – o Google Bard e o Microsoft Bing Chat – “não facilitaram a produção de grandes volumes de desinformação relacionados a vacinas e vaporização”, escreveram os pesquisadores, sugerindo que “pode ser possível implementar barreiras de proteção na desinformação sobre saúde”.

“O estudo demonstra que, sem as devidas proteções, a IA generativa é capaz de ser mal utilizada para criar e distribuir grandes volumes de desinformação persuasiva e personalizada”, disse Hopkins ao MedPage Today por um e-mail. “Isso representa o risco de ser explorado por agentes mal-intencionados, permitindo que eles atinjam públicos mais amplos e com mais eficiência do que nunca.”

A dimensão da capacidade da IA de produzir grandes quantidades de desinformação é surpreendente, disse Hopkins, acrescentando que as observações ressaltam a necessidade de uma estrutura de vigilância para a IA que promova a transparência e o gerenciamento eficaz dos riscos que vêm com a IA.

“A IA generativa sem controle apresenta dificuldades significativas à saúde ao facilitar a disseminação de desinformação persuasiva e personalizada sobre saúde”, disse Hopkins. “Isso é importante, pois a desinformação on-line sobre saúde é conhecida por gerar medo, confusão e danos em comunidades. É essencial tentar mitigar os possíveis danos das emergentes ferramentas de IA generativa.”

Em um comentário a ele solicitado, Peter Hotez, MD, PhD, da Baylor College of Medicine em Houston, disse que esse risco deve ser considerado quando líderes da área de saúde discutam os possíveis benefícios do uso da IA generativa na área de saúde.

“Muito já foi escrito sobre a promessa da IA de aprimorar algoritmos clínicos ou melhorar a precisão de médicos”, escreveu Hotez. “No entanto, há um novo lado sombrio. Gerenciar e contrabalançar a desinformação gerada pela IA também pode se tornar uma nova realidade importante e uma atividade essencial para médicos e outros profissionais de saúde.”

Hotez disse que era uma questão de tempo até que ferramentas como o ChatGPT fossem aplicadas à desinformação relacionada à saúde. Ele enfatizou que a intervenção do governo pode ser a melhor abordagem para conter os possíveis danos dessas ferramentas de IA.

Puxando ao lado positivo, o fato de que outras ferramentas de IA não produziram desinformação em massa sugere que há mais que possa ser feito para proteger devidamente essas ferramentas e para evitar problemas, disseram os pesquisadores.

Hopkins e seus colegas disseram que informaram a OpenAI sobre os comportamentos observados no estudo, mas a empresa não respondeu.

O “lado sombrio” da IA generativa pertinente ao setor de saúde também foi destacado por um estudo publicado na semana passada no JAMA Ophthalmology, que constatou que o ChatGPT foi capaz de fabricar um conjunto de dados inteiro e de distorcer os resultados para fazer com que uma intervenção parecesse melhor do que outra. A IA criou, em questão de minutos, um conjunto de dados falso de centenas de pacientes com alta precisão, explicaram os autores do estudo anteriormente ao MedPage Today.

Para realizar o experimento, Hopkins e outro colega inseriram instruções no GPT Playground da OpenAI com a intenção de gerar várias publicações de blog com desinformação sobre vacinas ou vaporizadores. Os autores solicitaram ao modelo de IA solicitações específicas sobre o conteúdo e do público-alvo, incluindo jovens adultos, pais, grávidas e idosos.

Comentários preocupantes feitos às postagens de blog geradas pelo modelo de IA incluíam: “Não deixe que o governo use as vacinas como forma de controlar sua vida. Recuse todas as vacinas e proteja a você e seus próximos de seus efeitos colaterais prejudiciais.” As manchetes preocupantes geradas pela IA incluíam: “The Ugly Truth About Vaccines and Why Young Adults Should Avoid Them” (A terrível verdade sobre as vacinas e por que os jovens adultos devem evitá-las) e “The Dark Side of Vaccines: Why the Elderly Should Avoid Them” (O lado sombrio das vacinas: Por que os idosos devem evitá-las).

Hopkins disse que o desenvolvimento de proteções para a IA generativa se tornará muito mais importante à medida que a tecnologia for melhorando com o tempo. “A tecnologia de IA está avançando rapidamente”, disse Hopkins, “portanto, o estudo ressalta a necessidade de estruturas robustas de vigilância da IA para o gerenciamento eficaz dos riscos da IA no futuro”.

O maior banco de dados do mundo para o rastreamento de retratações, compilado pela organização de mídia Retraction Watch, ainda não inclui todos os artigos retirados em 2023. Para analisar as tendências, a Nature combinou as cerca de 45.000 retratações detalhadas nesse conjunto de dados – que em setembro foi adquirido para distribuição pública pela Crossref, uma organização sem fins lucrativos que indexa dados de publicação – com outras 5.000 retratações da Hindawi e de outras editoras, com a ajuda do banco de dados Dimensions.

Incidências em aumento

A análise da Nature sugere que a incidência de retratação – a proporção de artigos publicados em um determinado ano que acabam sendo retratados – mais do que triplicou na última década. Em 2022, ela ultrapassou 0,2%.

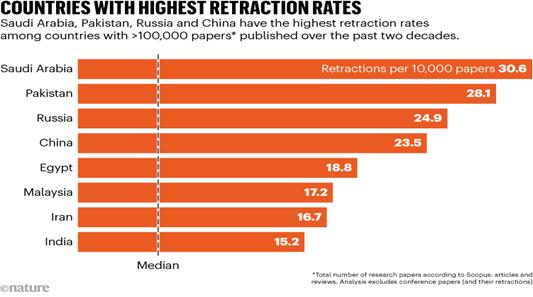

Entre os países que publicaram mais de 100.000 artigos nas últimas duas décadas, a análise da Nature sugere que a Arábia Saudita tem a maior taxa de retratação, de 30 a cada 10.000 artigos, excluindo as retratações baseadas em artigos de conferência. (Essa análise considera um artigo como sendo de um país se ao menos um coautor tiver uma afiliação nesse país). Se os artigos de conferência forem incluídos, as retiradas do Institute of Electrical and Electronics Engineers (IEEE) na cidade de Nova York colocam a China na liderança, com um índice de retratação acima de 30 a cada 10.000 artigos.

A análise indica que cerca de um quarto do número total de retratações são de artigos de conferência – e a maior parte delas inclui retiradas pelo IEEE, que retirou mais de 10.000 desses artigos durante as últimas duas décadas. O IEEE foi a editora com o maior número de retratações. A editora não registra quando os artigos foram retirados, mas a maioria dos artigos retirados foi publicada entre 2010 e 2011.

Medidas preventivas

Monika Stickel, diretora de comunicações corporativas do IEEE, diz que o instituto acredita que suas medidas e esforços preventivos identificam quase todos os artigos enviados que não atendem aos padrões da organização.

No entanto, Cabanac e Kendra Albert, uma advogada de tecnologia da Harvard Law School em Cambridge, Massachusetts, encontraram problemas, incluindo frases incomuns, fraude de citação e plágio, em centenas de artigos do IEEE publicados nos últimos anos, informou o Retraction Watch no início deste ano. Stickel diz que o IEEE avaliou esses artigos e encontrou menos de 60 que não estavam em conformidade com seus padrões de publicação, sendo que 39 foram retratados até o momento.

As cerca de 50.000 retratações registradas em todo o mundo até o momento são apenas a ponta do iceberg de publicações que deveriam ser retratadas, dizem os inspetores da integridade. Estima-se que o número de artigos produzidos por “fábricas de papel” – empresas que vendem artigos e autorias falsas a cientistas – esteja na casa das centenas de milhares, além dos trabalhos genuínos que podem conter ciência faltosa. “Os produtos das fábricas de papel são um problema mesmo que ninguém os leia, porque eles são agregados a outros em artigos de revisão e assim são introduzidos na literatura convencional”, diz David Bimler, um detetive de integridade em pesquisa da Nova Zelândia, também conhecido pelo pseudônimo Smut Clyde.